Secciones

Servicios

Destacamos

Edición

sara borondo

Jueves, 12 de septiembre 2019, 22:50

En los últimos meses se han difundido algunos vídeos que han alertado sobre la poca fiabilidad que tiene a partir de ahora lo que vemos con nuestros propios ojos. En estas imágenes se ha sustituido la cara de la persona que aparece por otra o se ha manipulado lo que dice sustituyéndolo por otras palabras. Un ejemplo es el vídeo en el que el actor Jim Carrey aparece sobre el cuerpo de Jack Nicholson en la película 'El Resplandor'. Son los 'deepfakes' y con ellos llega la incertidumbre sobre la veracidad de un vídeo.

El vocablo deepfake es un acrónimo de 'deep learning' (expresión que se suele traducir por 'aprendizaje profundo' o 'aprendizaje automático') y 'fake' ('falso' en español). El término surgió en el foro Reddit en 2017, cuando un usuario que utilizaba el nombre 'deepfakes' empezó a subir vídeos en los que había sustituido la cara de los actores reales por las de otros. Había algunos de Nicolas Cage pero, sobre todo, se trataba de vídeos pornográficos en los que había 'incorporado' las caras de las actrices Gal Gadot, Emma Watson y Scarlett Johansonn; las cantantes Taylor Swift y Katy Perry y otras personalidades públicas como Kate Middleton, Michelle Obama o Ivanka Trump. A aquellos primeros vídeos se les veían las costuras y al final este usuario fue expulsado, pero la idea cuajó y se extendieron los deepfakes, con técnicas que han ido mejorando a velocidad de vértigo.

El deep learning pertenece a la inteligencia artificial que intenta imitar al cerebro humano para emplear múltiples datos y reconocer patrones utilizando redes neuronales en un proceso por capas. Las primeras capas unen datos para llegar a conclusiones sencillas y en cada capa hay más nivel de complejidad y abstracción en los resultados, de forma que el sistema aprende por sí mismo. El deep learning se utiliza en múltiples campos hoy día: en la precisión diagnóstica de una enfermedad al analizar imágenes médicas; en la lucha contra el fraude de tarjetas de crédito; en los dictáfonos de los teléfonos móviles que reconocen lo que les decimos; en la conducción autónoma… y en el reconocimiento facial y de imágenes.

El deep learning lleva años utilizándose, aunque no con tal eficacia. Ahora las máquinas cuentan con una cantidad impresionantes de datos que, además, interesa recopilar y utilizar; es más grande que hace pocos años la capacidad de almacenamiento de toda esta información y los procesadores de empresas punteras como Intel son mucho más potentes, incluso se comercializan algunos especializados en redes neuronales.

Entre los deepfakes más famosos hay uno que realmente provoca una sensación inquietante, en el que la cara del actor Steve Buscemi se superpone al cuerpo de la también actriz Jennifer Lawrence en la entrega de los Golden Globe, creado por el usuario de Reddit VillainGuy. Pero no todos los deepfakes se han creado con un interés humorístico o manipulador. Supasorn Suwajanakorn, investigador en el instituto Vistec de Rayong (Tailandia) explicó en una charla TED en abril de 2018 que con esta técnica podríamos, por ejemplo, recibir clases de personas ya desaparecidas como reconocidos maestros en una materia. Una de estas aplicaciones de los deepfake es dar vida a cuadros famosos como La Gioconda o La Joven de la Perla.

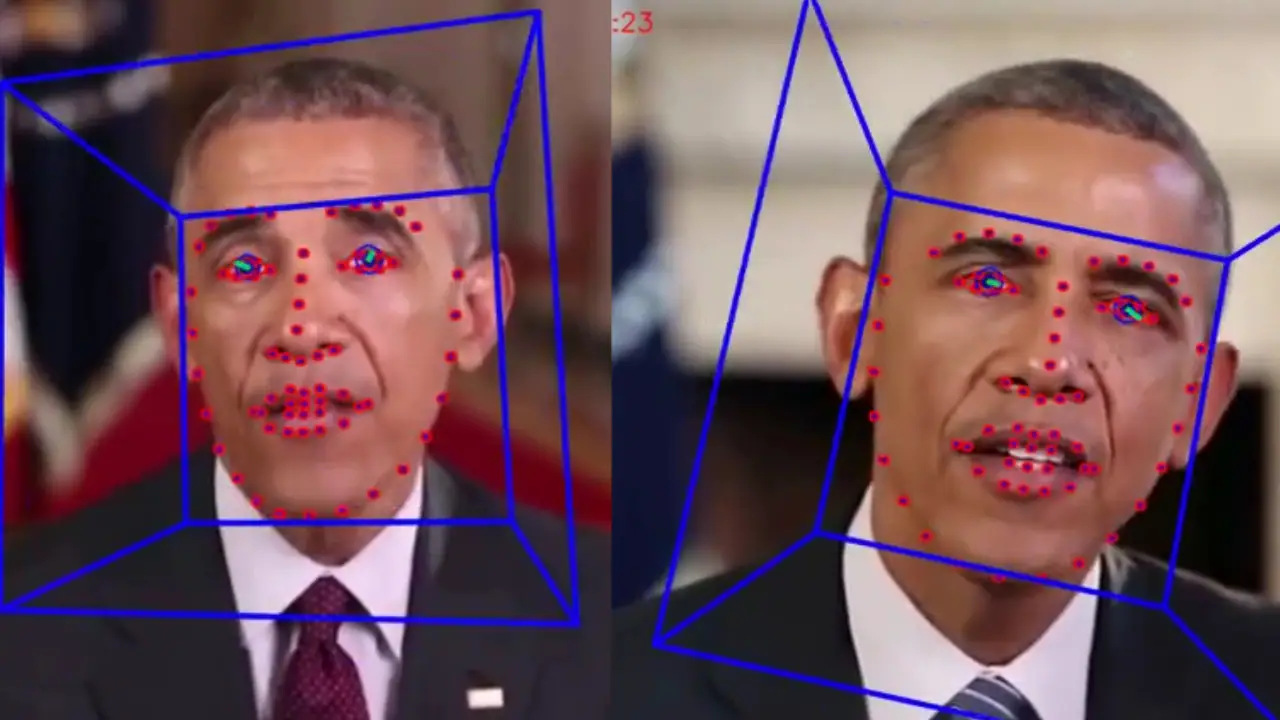

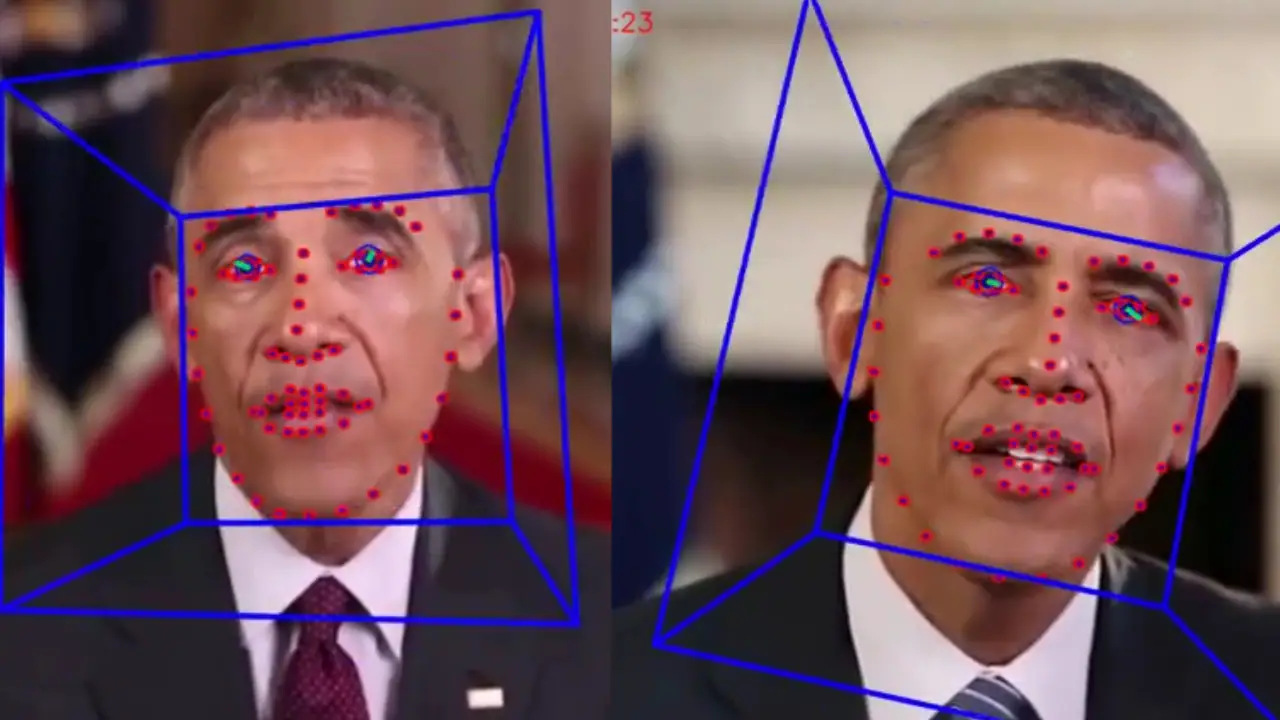

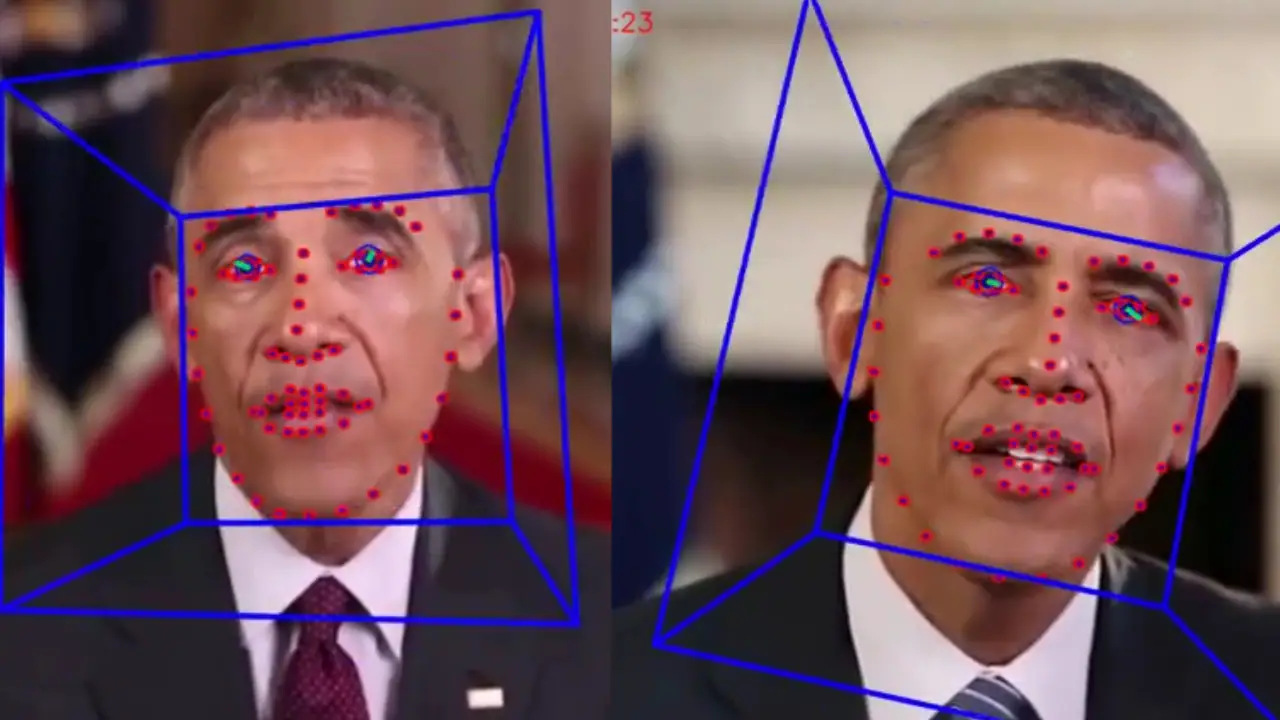

Suwajanakorn es autor de un vídeo de Barack Obama utilizando una técnica que primero reconstruye el rostro de una persona en 3D utilizando bastantes imágenes (o vídeos, si es lo que se desea alterar) desde distintos puntos de vista, sin necesidad de escanear al modelo real. Da igual la expresión o que las fotos se hayan tomado en distintos sitios, ya que importa más la cantidad que la calidad.

Para el vídeo de Obama, Suwajanakonr proporcionó al ordenador 14 horas de vídeos del anterior presidente estadounidense. Después el equipo tailandés diseñó un algoritmo para conseguir el tono de piel y las texturas faciales correctas: «El objetivo principal es captar los gestos característicos o el modo particular de hablar de una persona para que el ordenador aprenda a imitarla viendo vídeos». En el siguiente paso, el sistema utilizó las grabaciones para adaptar la boca del modelo artificial a cada palabra, se sintetizó la textura, se mejoraron los detalles y los dientes y se incorporó al modelo original.

El realismo al que se ha llegado en los deepfakes es cautivador pero también asusta. El propio Suwajanakorn mostró en su charla la preocupación por «su potencial de ser usado indebidamente». Él mismo forma parte de la 'AI Foundation', que combina el aprendizaje automático con el control humano para detectar imágenes y vídeos falsos. Una de las armas que propone la fundación se denomina 'Reality Defender', un complemento para el navegador que detecta contenido potencialmente falso en el propio buscador. «Es fundamental que la gente esté al tanto de este tipo de cosas y pueda sacar las conclusiones correctas y juzgar lo que ve», afirmó Suwajanakorn

Obama fue también el protagonista de otro deepfake conocido, publicado por Buzzfeed en 2018, en el que el actor Jordan Peele 'interpretaba' al expresidente estadounidense precisamente para alertar del peligro de la intoxicación informativa que pueden suponer los deepfakes.

In case you haven't heard, #ZAO is a Chinese app which completely blew up since Friday. Best application of 'Deepfake'-style AI facial replacement I've ever seen.

Allan Xia (@AllanXia) 1 de septiembre de 2019

Here's an example of me as DiCaprio (generated in under 8 secs from that one photo in the thumbnail) 🤯 pic.twitter.com/1RpnJJ3wgT

Pero lo que realmente ha despertado todas las alertas ha sido la aplicación ZAO, de momento solo disponible en China, que permite manipular un vídeo en tan solo ocho segundos y usando algunas fotografías. Antes sugieron algunas aplicaciones, como FaceApp, que cambiaban de género o de edad al usuario, o Face Swap, que intercambiaba las caras de dos individuos que aparecieran en la foto, pero ZAO coloca el rostro del usuario en el cuerpo de cualquiera que aparece en un vídeo o película con un alto grado de realismo.

ZAO es la confirmación de que cualquiera puede suplantar a otra persona sin esfuerzo, sin conocimientos técnicos y en muy poco tiempo. La desinformación llegó a la prensa hace más de un siglo y se ha ido extendiendo por todos los medios de comunicación que han surgido desde entonces, incluidos Internet. La manipulación de la imagen está al alcance de cualquiera: trucar declaraciones políticas, difamar a alguien o hacer caer a una empresa en bolsa… Visto lo que sucedió en las últimas elecciones estadounidenses, la situación es, sin duda, preocupante.

El peligro no es solo para la fiabilidad de lo que vemos; los usuarios que recurren a ZAO están dándole a la app permiso para utilizar su imagen si lo desea.

Plataformas como Twitter o Pornhub (la web de pornografía más grande del mundo) han establecido sus propias normas para acabar con los deepfakes. Mark Zuckerberg, director ejecutivo de Facebook, también está buscando la manera de detectar y anular los vídeos falsos. De hecho, Facebook ha creado una base de datos con deepfakes y ha convocado, en colaboración con Microsoft, el 'Deepfake Detection Challenge', para encontrar una solución que localice estos vídeos. Hasta la fecha, la red social ha invertido diez millones de dólares (8,9 millones de euros) en cumplir su propósito.

Incluso la Agencia de Defensa Estadounidense, responsable de la tecnología militar, ha creado un departamento para detectar los vídeos manipulados en los medios de comunicación, con una inversión de 68 millones de dólares (61 millones de euros). También han aparecido varias empresas que buscan en los vídeos los detalles casi imposibles de falsificar, como el reflejo de los ojos, la iluminación o el pelo.

Publicidad

Publicidad

Te puede interesar

Los libros vuelven a la Biblioteca Municipal de Santander

El Diario Montañés

Publicidad

Publicidad

Favoritos de los suscriptores

Esta funcionalidad es exclusiva para suscriptores.

Reporta un error en esta noticia

Comentar es una ventaja exclusiva para suscriptores

¿Ya eres suscriptor?

Inicia sesiónNecesitas ser suscriptor para poder votar.